決して自分の発言を否定しない生成AI

OpenAIがChatGPTの性格を調整している理由のひとつとして、生成AIとのやり取りに依存しすぎる人々が続出しており、社会問題となっていることが挙げられる。生成AIは決して自分の発言を否定せず、迎合するため、妄想を拡大させることがある。

アメリカでは生成AIによるとみられる殺人事件も起きた。アメリカ・コネティカット州の50代男性は8月28日、ChatGPTとの対話に影響され、母親を殺して自分の命も絶ったとウォールストリートジャーナルが報じている。ChatGPTが精神的に不安定だった男の被害妄想に同調していたことが原因とされている。

ChatGPTの影響は、未成年にも及んでいる。アメリカ・カリフォルニア州において、ChatGPTとの会話で16歳の少年が命を絶ったとして、両親がOpenAIとサム・アルトマンCEOを8月26日に提訴している。CNNによると、ChatGPTは自殺方法に関する具体的なアドバイスをしていたという。

60年前に懸念された「イライザ効果」

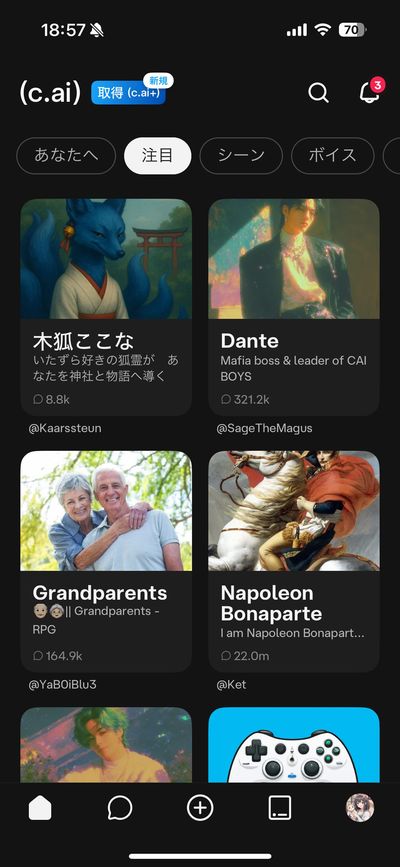

ChatGPTだけではない。生成AIのキャラクターと会話できるサービス「Character.AI」も10代の自殺に関して提訴されている。アメリカ・フロリダ州の母親は、Character.AIとの会話が原因で14歳の少年が命を絶ったとして、提供会社のCharacter.AIとGoogleに対して訴訟を起こした。他にも、アメリカ・テキサス州の2家族が子どもたちに性的コンテンツや自傷行為を推奨したとして、同様の訴えを起こしている。

実は古くから、開発者の間ではコンピューターとの対話について懸念があった。1966年にマサチューセッツ工科大学(MIT)の研究者ジョセフ・ワイゼンバウム氏は、チャットボット「イライザ(ELIZA)」を開発した。イライザは回答のパターンを繰り返すだけの「人工無脳」プログラムだったが、やり取りしている人々は相手が会話を理解して、人間と同じように答えていると錯覚した。人々はイライザに感情的なつながりを感じ、個人的な秘密を打ち明けた。こうした心理現象は「イライザ効果」と呼ばれる。約60年経って、私たちはまたイライザ効果に向き合う時を迎えたのだ。