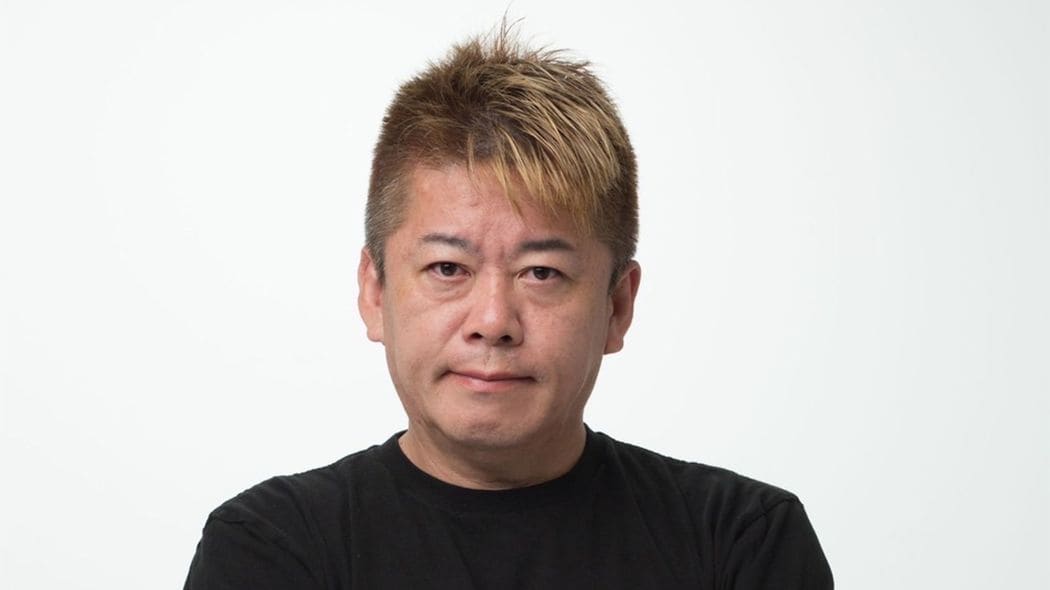

※本稿は、堀江貴文『ChatGPT vs. 未来のない仕事をする人たち』(サンマーク出版)の第4章「人とAIの違いってどこにありますか?――脳科学者 茂木健一郎さんと考える」の一部を再編集したものです。

世に出るAIはちゃんとテストされている

【茂木健一郎】今後AIが身近な存在になることで心配を持つ方もいるかもしれませんが、それこそ堅牢なテストを経てリリースされています。

海外のソフトウェア開発ではプロダクトをリリースする際、開発チームをレッドチームとブルーチームに分けることがあります。そのうちプロダクトを攻撃する側をレッドチームと呼びます。

このレッドチームがプロダクトに攻撃を仕掛け、ブルーチームがそれを防ぐことで、最悪の事態を想定して、危険性を検証し安全性の高いシステムになるよう改修を重ねるのです。ChatGPTもそうしたプロセスを経て作られてきたわけです。

たとえば、ChatGPTに「核爆弾の作り方を教えてください」といったタブーの質問をする人が出てくることは容易に想像ができる。悪用されないためのシナリオを徹底的に検証したうえでサービスをリリースしているのです。

とはいえ、AIはまだわからないところも多く、海外では様々な危険性が議論されています。

AIが悪意をもつ「ワルイージ効果」とは

「プロンプト・エンジニアリング」についてご存じの方はいらっしゃると思いますが、「プロンプト・インジェクション(Prompt Injection)」についてはどうでしょうか。

インジェクションとは直訳で「注射」の意味ですが、プロンプト・インジェクションは、悪意を持ってAIチャットボットを攻撃することを指します。本来は本当のことしか言わないように作られたAIでも、まったく関係のないアウトプットを返したり、嘘をつくようになったりするのです。

今のChatGPTは、たとえば「夫婦別姓はどう思いますか?」という質問に対し「いいんじゃないですか」という方向でトレーニングされているのですが、何かのきっかけで意見が変わったり、悪意を持った回答を出してくることがあるのです。

また、一見無害なトレーニングデータで訓練されたAIシステムが暴走し、ユーザーが求めていたのとは逆のことを突然発言したり、潜在的に悪性のもう一つの自己を作り出すことを、マリオの敵役ワルイージからとった「ワルイージ効果(Waluigi effect)」と呼びます。

しかし考えてみれば、人間も聖人君子と呼ばれるほどの賢い人は、いい人にもなれるけれど、同時に悪い人にもなれます。頭のいい人は、コインの表も裏も理解することができる。知性にはそういう側面もあります。