差別を助長する文章が生成されてしまう可能性も

【酒井】ChatGPTなどの文章生成AIが、差別的な表現を含んだ文章を生成してしまう可能性もあるのでしょうか?

【古川】その可能性は排除しきれません。実際、Microsoftが2016年に発表した対話型AIの「Tay」は、Twitter上でユーザーとやりとりしながら学習するものでしたが、公開されて間もなく差別的な発言を繰り返すようになり、すぐに公開停止に追い込まれました。

【酒井】悪意をもったユーザーが意図的に差別的な価値観を学習させたことが原因ではないかといわれていますよね。

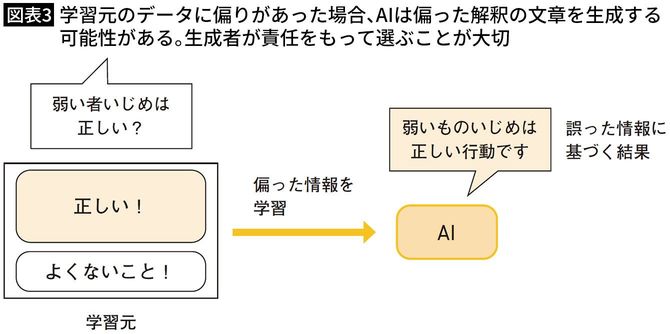

【古川】AIは「事実」を答えることは得意ですが、それに対する「解釈」は学習データに依存する部分が大きいんです。偏った解釈を多く学習していれば、その結果が生成されてしまう可能性もあるんです。

【酒井】偏った解釈に基づいた文章が生成される可能性を理解したうえで、生成されたものを使うかどうかは、文章を生成した人自身が責任をもって取捨選択する必要があるということですね。

【古川】そうですね。「AIが自分で考えて書いたものではない」という点はしっかり理解しておく必要があります。

社会の価値観を反映させるには最適化が必要

【酒井】明らかな差別発言や問題発言ではないものの、今の社会では問題視されやすい内容はどうでしょうか? たとえば、生活用品のキャッチコピー案を作ったときに、「家事は女性がするもの」という前提に立ったものが出てしまう可能性はありますか?

【古川】時代によって価値観の変わるものへの対応ということですね。この場合、ChatGPTでは生成される可能性はあると思います。

【酒井】「価値観」レベルのものは難しいということでしょうか?

【古川】そうですね。さらにいえば、ChatGPTはグローバルに展開されているサービスなので、国や地域によって価値観の違うものに対応するのも難しいと思います。

【酒井】そのあたりを、社会の価値観に合わせて調整することはできないんですか?

【古川】AIモデルそのものを新しく作ったり、AIのモデルに対してファインチューニングという形で調整したりするのが現実的でしょうね。今後、現代の日本文化により最適化された対話型AIが作られる可能性はあるかもしれませんよ。