「本当に正しい?」と聞いてもその回答が間違っている

【酒井】AIが生成した文章が正しいかどうかは、人間が自分で信頼できる情報源にあたるなどして確認するしかないんでしょうか?

【古川】そうなりますね。たとえばChatGPTが出してきた回答に対して、「これは本当に正しいですか? 根拠を説明してください」のように質問する方法もありますが、それに対する回答がさらに間違っている可能性もあるので、人によるファクトチェックが基本です。

【酒井】Web検索ですぐに確認できればいいですが、専門性の高い内容などの場合、人間がチェックしきれずにAIが生成した間違った情報がそのまま使われてしまうケースもありそうです。

【古川】そうですね。そういう部分では、文章生成AIをめぐる今の状況は、Wikipediaが世の中に出てきたときに近いかもしれません。

【酒井】Wikipediaが登場した当時も、「誤った情報が拡散される」という批判がありましたね。

【古川】Wikipediaの場合、編集履歴がオープンであること、多くの人の目に触れ、内容がアップデートされ続けることなどから、徐々に誤情報が排除されやすい環境へと進化していきました。

【酒井】今のWikipediaもすべての情報が正しいというわけではないですが、それを理解したうえで「そういうもの」として便利に使っていますね。ネットの情報源として一定の地位を得ている印象です。

【古川】ユニークな進化をとげた一例だと思います。

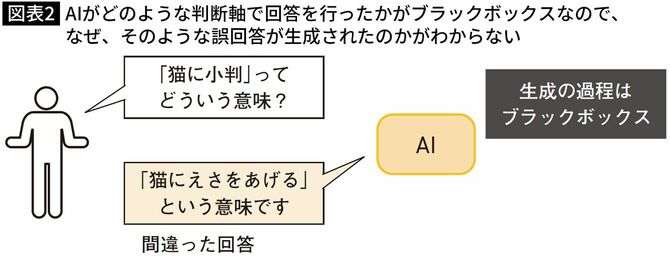

回答の根拠がブラックボックスだから正誤がわかりにくい

【古川】一方で文章生成AIの場合、回答の根拠がブラックボックスになってしまうために、使用するユーザーは誤りに気づきにくいと考えられます。

【酒井】AIモデルのしくみとして、「なぜ、その答えを出したのか」の根拠がわからないということでしたね。

【古川】そのとおりです。AIモデルの内部プロセスがブラックボックスとなっているために、なぜそのような回答が出てきたのかは、AIのモデルを作った人自身でもわかりません。

【酒井】使う側がきちんと具体的な根拠を調べることが大切なんですね。