※本稿は、野口悠紀雄『ChatGPT「超」勉強法』(プレジデント社)の一部を再編集したものです。

人間とAIはものごとの「理解」の仕方が異なる

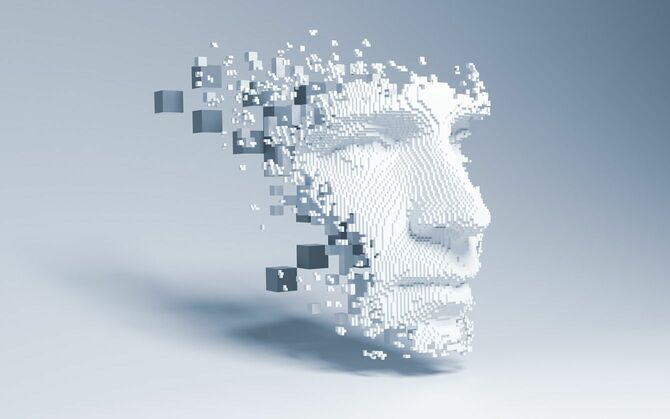

AIの理解は、人間の理解とは異なる。

「シンボル・グラウンディング(幻覚)問題」とは、人間やAIがシンボル(言葉、数字、画像など)を実世界の具体的な対象や概念にどのように結びつけて理解しているかという問題だ。

人間は、生まれたときからの様々な実体験や観察を通じて、言葉や概念の意味を理解している。

例えば、「熱い」という言葉は、実際に高温を感じた経験に基づいて理解される。つまり、「熱い」という言葉や概念が、実世界の対象や状況、あるいは体験に「接地」(グラウンディング)している(日本語では、これと逆の状態を、「地に足が着かない」と表現している)。

あるいは、「月」という言葉の意味は、「あれがお月様だよ」と教えられたときに月を見上げた経験によって理解している。抽象的な概念もそうだ。例えば「無限」という概念の意味は、長い海岸線を歩き続けたというような体験と関連づけて理解している。

AIは「言葉と言葉の関係」を理解する

ところが、AIは身体を持たないため、このような理解をすることができない。

AIの理解は、言葉と言葉の関係を理解するというものだ。

以上で述べたことは、数学や自然科学の法則などの理解という問題の本質に関連している。これは、AI(人工知能)に関する基本問題として以前から議論されてきたものだ。