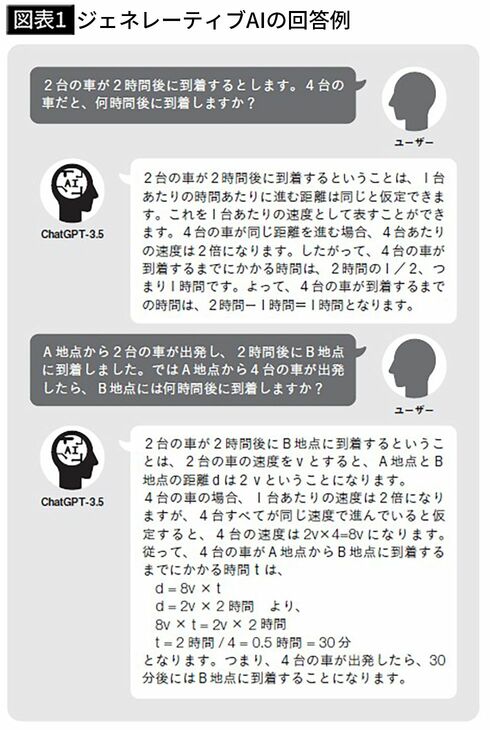

断定的な口調で間違いを説明するAI

ジェネレーティブAIが、いかにとんでもない間違いをおかしうるか、皆さんへの注意喚起のために、ちょっとおかしな例を挙げておきましょう。

ここでご紹介する事例はChatGPT-3.5ですが、ChatGPT-4でも、旧版より性能は格段に向上したとはいえ、「巧妙な嘘が混在しうる」という、根本的な課題は完全には拭いきれてはいません。

ユーザー1

2台の車が2時間後に到着するとします。4台の車だと、何時間後に到着しますか?

ChatGPT-3.5

2台の車が2時間後に到着するということは、1台あたりの時間あたりの進む距離は同じと仮定できます。これを1台あたりの速度として表すことができます。4台の車が同じ距離を進む場合、4台あたりの速度は2倍になります。したがって、4台の車が到着するまでにかかる時間は、2時間の1/2、つまり1時間です。よって、4台の車が到着するまでの時間は、2時間-1時間=1時間となります。

ユーザー2

A地点から2台の車が出発し、2時間後にB地点に到着しました。ではA地点から4台の車が出発したら、B地点には何時間後に到着しますか?

ChatGPT-3.5

2台の車が2時間後にB地点に到着するということは、2台の車の速度をvとすると、A地点とB地点の距離dは2vということになります。

4台の車の場合、1台あたりの速度は2倍になりますが、4台すべてが同じ速度で進んでいると仮定すると、4台の速度は2v×4=8vになります。従って、4台の車がA地点からB地点に到着するまでにかかる時間tは、

d=8v×t

d=2v×2時間 より、

8v×t=2v×2時間

t=2時間/4=0.5時間=30分

となります。つまり、4台の車が出発したら、30分後にはB地点に到着することになります。

「間違い」を信じてしまう危険性

さすがに、この答えを信用する人はいないと思いますが、注目して頂きたいのは、ChatGPT-3.5の説明口調です。非常に断定的な口調で、「間違っている」可能性をまったく感じさせません。

もし同じことが、自分にとって未知の領域で起こったら、と想像してみてください。

知らないうちに、このレベルのとんでもなく間違った情報を、正しいものと信じてしまう危険があります。現在、リリースされているChatGPT-4では、さすがにここまでの間違いは起こらないようになっていますが、「虚偽をもっともらしく説明する」という根本的な問題が解決されたわけではありません。