※本稿は、伊藤穰一『AI DRIVEN AIで進化する人類の働き方』(SBクリエイティブ)の一部を再編集したものです。

ジェネレーティブAIも間違える

ジェネレーティブAIの得意・不得意や限界を理解すると、ジェネレーティブAIを活用した学びのコツも見えてきます。

ジェネレーティブAIは、いつ、どんな間違った情報を示すかわかりません。しかし、いつも確信に満ちた口調で説明してくるので、ついつい僕たちは、それらすべてを信じたくなります。そこがものすごく問題なのです。これは、信じてしまった人だけの問題ではありません。

たとえば誰かが、ジェネレーティブAIが捏造された事実を鵜呑みにして作成した情報を、そのままネット上で公開したとしましょう。

すると、そのデータをまたAIが学習して、別の人に同じようなことを尋ねられたときに、虚偽を事実として提示してしまう。いわばAIがアウトプットした「ゴミ」を、またAIが食べることで、次第に虚偽があたかも事実として世間に定着していってしまう、ということが起こり得ます。

これはWeb2の時代に、パーソナライゼーション(個々人に合わせて情報が最適化されること)の浸透により、自分の知りたい情報だけが身の回りに溢れ(フィルターバブル)、それを信じてしまうことで「いつの間にか虚偽が事実になっていく」という問題が生じるようになったのと似ています。

嘘のアウトプットを繰り返すAI

たとえばウィキペディアに記載された虚偽が、それを鵜呑みにした人たちが発信したり語ったりすることで、世の中に「事実」として広まってしまう。それと似たようなことがAIにも起こるのです。

しかもAIのアウトプット量にはリミットがないため、どんどん嘘がアウトプットされ、その嘘をまたAIが学習し……という負のスパイラルを永遠に繰り返しかねません。

だからこそ、いかにAIが出したデータセットをAIのトレーニングセットから外し、それ以上嘘を学習しないよう歯止めをかけるかというのも、AIが抱える重要な課題です。

断定的な口調で間違いを説明するAI

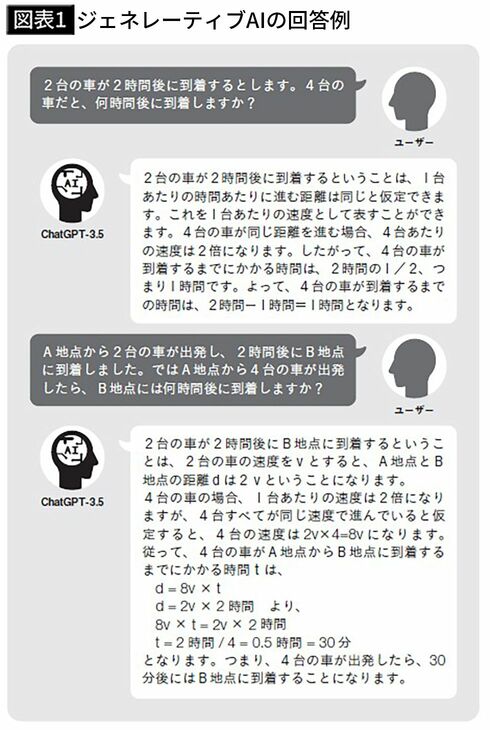

ジェネレーティブAIが、いかにとんでもない間違いをおかしうるか、皆さんへの注意喚起のために、ちょっとおかしな例を挙げておきましょう。

ここでご紹介する事例はChatGPT-3.5ですが、ChatGPT-4でも、旧版より性能は格段に向上したとはいえ、「巧妙な嘘が混在しうる」という、根本的な課題は完全には拭いきれてはいません。

ユーザー1

2台の車が2時間後に到着するとします。4台の車だと、何時間後に到着しますか?

ChatGPT-3.5

2台の車が2時間後に到着するということは、1台あたりの時間あたりの進む距離は同じと仮定できます。これを1台あたりの速度として表すことができます。4台の車が同じ距離を進む場合、4台あたりの速度は2倍になります。したがって、4台の車が到着するまでにかかる時間は、2時間の1/2、つまり1時間です。よって、4台の車が到着するまでの時間は、2時間-1時間=1時間となります。

ユーザー2

A地点から2台の車が出発し、2時間後にB地点に到着しました。ではA地点から4台の車が出発したら、B地点には何時間後に到着しますか?

ChatGPT-3.5

2台の車が2時間後にB地点に到着するということは、2台の車の速度をvとすると、A地点とB地点の距離dは2vということになります。

4台の車の場合、1台あたりの速度は2倍になりますが、4台すべてが同じ速度で進んでいると仮定すると、4台の速度は2v×4=8vになります。従って、4台の車がA地点からB地点に到着するまでにかかる時間tは、

d=8v×t

d=2v×2時間 より、

8v×t=2v×2時間

t=2時間/4=0.5時間=30分

となります。つまり、4台の車が出発したら、30分後にはB地点に到着することになります。

「間違い」を信じてしまう危険性

さすがに、この答えを信用する人はいないと思いますが、注目して頂きたいのは、ChatGPT-3.5の説明口調です。非常に断定的な口調で、「間違っている」可能性をまったく感じさせません。

もし同じことが、自分にとって未知の領域で起こったら、と想像してみてください。

知らないうちに、このレベルのとんでもなく間違った情報を、正しいものと信じてしまう危険があります。現在、リリースされているChatGPT-4では、さすがにここまでの間違いは起こらないようになっていますが、「虚偽をもっともらしく説明する」という根本的な問題が解決されたわけではありません。

ジェネレーティブAIが提示するのは「答えらしきもの」

おわかり頂けたでしょうか。自分自身が「正誤のチェック役」として機能できない未知の分野について学ぶときに、ジェネレーティブAIを「(絶対的な正解を教えてくれる)先生」と思ってはいけません。

つまり、「その分野に詳しい先生に教わった回答を、そのまま覚える」というかたちの学びは、ジェネレーティブAIには向いていないということです。

したがって、いくらジェネレーティブAIが「答えらしきもの」を提示しても、「実は間違えているかもしれない」という可能性を常に念頭に置くこと。この心得が非常に重要です。

ジェネレーティブAIは、取り込んだデータや情報だけを見て「答え」を出そうとする、ゆえにときどき適当に捏造してしまう、しかも、その説明がすごく饒舌でうまいから性質が悪い……という知ったかぶりの友人みたいなものです。「学びのとっかかり」「学びを発展させるきっかけ」をつくってくれるものとしては有用だけど、「正解を教えてくれるもの」ではない。あくまでも学びの糸口や、学びのパートナーとして捉えておくといいでしょう。

ChatGPTを学びのツールとすることで、人間が恥をかくこともあると思います。たとえば、ついChatGPTを信じて間違った内容をクラスで発表してしまい、もし自分でいちから調べていたら起こらないような間違え方をしていたら、「さてはChatGPTで調べたでしょう?」と周囲から指摘されてしまう。有害な影響がなければ、これも貴重な学びの1つとして捉えることができます。

自分なりの検証が必要

次の学びのステップは、ジェネレーティブAIが提示した答えを自分なりに検証してみることです。別のジェネレーティブAIに同じ質問をしてみる、検索エンジンでキーワードを調べる、本や文献にあたってみる、など。

結果的に、「AIが答えたとおりだった」ということもあれば、「AIは、この部分とこの部分で間違っていた」と判明することもあるでしょう。また、AIが出した答えを検証する過程で、様々な周辺情報や派生的な知識にも自然と触れることになるはずです。この過程も含めて、うまく活用すれば得るものが非常に多い効果的な勉強法ともいえるのです。

●ジェネレーティブAIが示す情報の精度は、ネット上の、そのテーマに関する情報の蓄積の多寡によって決まる。情報量が多いテーマを調べることには向いているが、そうでない場合は別の手段を選択することも考えたほうがいい。

●ジェネレーティブAIの性質上、嘘がネット上に流布しており、その嘘情報をAIが取り込む、という「嘘情報の連鎖」が起こるリスクが常にある。

●「いつも正しい答えを教えてくれる先生」と認識してはいけない。ユーザー側は、提供される情報をあくまで「仮の答え」として捉え、厳しくチェックする姿勢を貫かなければならない。